Apple a déclaré qu’il mettrait en place un nouveau programme majeur pour lutter contre la maltraitance des enfants. Ce que les défenseurs de la vie privée ont vivement critiqué.

Apple a officiellement annoncé la mise en œuvre de nouvelles mesures afin de lutter contre la maltraitance des enfants. La société a prévu d’appliquer ce programme dans les prochaines mises à jour iPadOS et iOS 15 pour ses appareils mobiles. Or, malgré le souhait de l’établissement de plaider pour une bonne cause, son plan a inquiété les défenseurs de la vie privée.

Dans cet article :

Apple prévoit trois actions pour surveiller les appareils mobiles des enfants

Tout d’abord, le logiciel d’Apple va commencer par analyser les photos dans l’application Message native iOS des appareils. Une nouvelle fonctionnalité d’activation avertira les mineurs et leurs parents quand ils reçoivent un message qui comporte des contenus sexuellement explicites. Si tel est le cas, les photos seront automatiquement floutées.

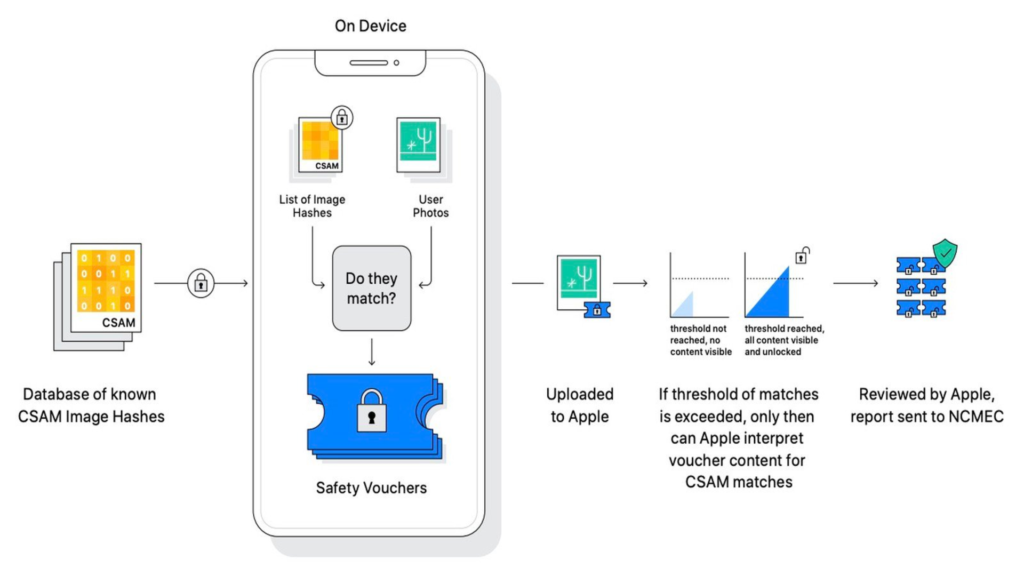

En outre, Apple fera la comparaison des photos téléchargées et stockées sur ses serveurs iCloud avec celles d’une banque de données de contenus abusifs connus. La société utilisera à cet effet NeutralHash, une technologie capable d’identifier et signaler les contenus abusifs.

Cependant, les défenseurs de la vie privée se préoccupent de la confidentialité des utilisateurs. Ils craignent surtout qu’Apple utilise cette technologie pour d’autres objectifs. Pour apaiser les tensions, l’entreprise a rassuré ses clients qu’elle ne violerait pas leur vie privée. De plus, elle a organisé une série de conférences de presse pour défendre sa réputation.

« Il est vraiment clair que beaucoup de messages se sont mélangés assez mal en termes de compréhension des choses »

Craig Federighi, vice-président senior de l’ingénierie logiciel d’Apple.

Comment fonctionne le nouvel outil ?

Apple a récemment souligné comment le nouveau système transformerait les photos sur iPhone et iPads en nombres complexes. De ce fait, le nouveau programme comparera les chiffres à une base de données de hachages fournie par le National Center for Missing and Exploited Children (NCMEC). À noter que cette action ne peut se faire que lorsque les images sont téléchargées sur le service de stockage iCloud d’Apple.

En fait, les iPhone et iPads créeront un « bon de sécurité » doublement crypté. Celui-ci se présente comme un paquet d’informations envoyé aux serveurs iCloud. Par ailleurs, quand un certain nombre de bons de sécurité correspondent aux photos de NCMEC, l’équipe d’examen d’Apple recevra une alerte.

Ainsi, la société peut désactiver le compte de l’utilisateur et signaler le NCMEC. Cet organisme peut donc informer les forces de l’ordre de l’existence d’images potentiellement abusives. Federighi a toutefois précisé qu’il faudrait atteindre environ 30 correspondances avant que le logiciel n’informe l’équipe d’examen d’Apple.

En bref, l’initiative d’Apple qui vise à instaurer de nouvelles mesures pour lutter contre l’exploitation des enfants est certes louable. Néanmoins, cet outil suscite de nombreuses inquiétudes auprès des utilisateurs et des défenseurs de la vie privée aux États-Unis. Malgré cette situation, le fabricant de l’iPhone n’a pas l’intention de faire marche arrière sur ces décisions. En effet, il prévoit même d’étendre ces dispositifs de sécurité à d’autres pays.

BuzzWebzine est un média indépendant. Soutiens-nous en nous ajoutant à tes favoris sur Google Actualités :